Das fliegende Auge – Bild- und Videoauswertung für UAVs

Bild- und Videoauswertung

Neben der Sensorik spielt die Auswertesoftware eine wesentliche Rolle bei der (Live-) Auswertung der Daten. Der beste Sensor kann nutzlos sein, wenn eine schlechte Auswertesoftware genutzt wird. Neben Verfahren zum Tracking von Personen und Objekten, wie z.B. Autos, sind bei Bildern und Videos von UAVs besonders Verfahren zur Verbesserung des Bildes erforderlich. Das liegt daran, dass einerseits das UAV sich bewegt und diese Bewegung in Verbindung mit einer zu großen Belichtungszeit zu einer gewissen Unschärfe der Bilder kommen kann. Andererseits ist der Speicherplatz für Daten begrenzt bzw. müssen die Daten per Funk übertragen werden. Um dennoch eine hohe Auflösung zu haben, bzw. ein Livebild über die Funkverbindung zu versenden, werden die Daten stark komprimiert, z.B. mit JPEG oder MPEG. Dadurch entstehen Komprimierungsartefakte, die abhängig vom Kompressionsgrad die Analyse des Bildes mehr oder weniger erschweren können. Um dennoch wichtige Informationen aus den Daten zu gewinnen, wird Bild- und Videoauswertesoftware verwendet, die mit Hilfe intelligenter Verfahren versucht die verlorene Information wieder zurückzugewinnen. Neben den erwähnten Bildstörungen, den sogenannten Artefakten, gibt es noch eine Vielzahl an weiteren Störungen, die auch von der gewählten Sensorik abhängen können. Bei mobilen Kameras mit CMOS-Sensor-Technik, die in vielen aktuellen Videokameras und Handys verwendet werden (auch in der Actionkamera GoPro), tritt insbesondere der sogenannte Rolling-Shutter-Effekt auf. Dies hängt damit zusammen, dass die Daten vom CMOS-Sensor zeilenweise ausgelesen werden und es dadurch bei bewegten Objekten oder bewegter Kamera zu Bildverzerrungen kommen kann. Kameras mit CCD-Sensor haben auf Grund der unterschiedlichen Funktionsweise kein Rolling-Shutter Problem. Alternativ gibt es auch Global-Shutter CMOS-Kameras, die allerdings preislich höher angesiedelt sind. Schließlich spielt auch die Beleuchtung eine wichtige Rolle. Überbelichtung, d.h. die Kamera wird geblendet und ein Bereich des Bildes wird weiß, kann Bildmaterial unbrauchbar machen, starke Beleuchtungsänderungen erschweren die Auswertung der Daten, z.B. zum Tracking von Objekten, und eine geringe Beleuchtung führt zu nicht sichtbaren/verfolgbaren Objekten, bzw. zu einer längeren Belichtungszeit und dadurch wieder zu mehr Bewegungsunschärfe. Die meisten Bildartefakte (starke Kompression, Beleuchtungsänderungen, Bewegungsunschärfe und niedrige Auflösung) sind unabhängig von der Anwendung bei UAVs, sondern gelten allgemein für Bild- und Videoaufnahmen. Im Allgemeinen existieren drei Arten von Verfahren zur Behebung bzw. zur Minimierung dieser Artefakte: (1) Verfahren, die die Informationen im Bild nutzen. Hierbei wird z.B. eine Kante detektiert und entsprechend bearbeitet. (2) Verfahren, die Informationen aus einem Video nutzen. Dabei wird u.a. die im Video sichtbare Bewegung zwischen Bildern berechnet und genutzt. (3) Lernbasierte Verfahren, die mit ähnlichen Bildern trainiert werden, damit sie „lernen“, wie sich Artefakte auf Bilder auswirken. Mit diesem Wissen lassen sich dann theoretisch umgekehrt bei bekannten Artefakten die ungestörten Bildinhalte wieder rekonstruieren.

Distante Biometrie

Bei der sog. distanten Biometrie geht es darum Personen in großer Entfernung zu detektieren, (wieder)zuerkennen und zu identifizieren. Detektieren bedeutet in dem Fall, dass eine Person in einem Bild erkannt wird, d.h. Kopf, Augen oder Mund werden gefunden. Dies ist im Allgemeinen ab einer Kopfgröße von ca. 6x6 Pixeln möglich. Die (Wieder-)Erkennung ist ab einer Kopfgröße von ca. 25x25 Pixeln möglich, und bedeutet, dass eine Person in mehreren Bildern an charakteristischen Merkmalen erkannt werden kann, z.B. sogenannte „soft“-biometrische Merkmale wie Frisur oder Brille. Für die Identifikation ist schließlich eine Kopfgröße von ca. 120 x 120 Pixel nötig. Die Identifikation erlaubt eine dauerhafte eindeutige Zuordnung, z.B. durch Gesichtserkennungsverfahren.

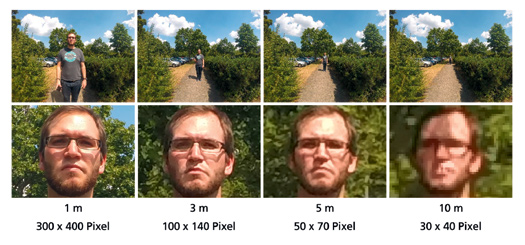

Abbildung 2: Darstellung der Gesichtsgröße in Pixeln bei unterschiedlichen Entfernungen zur Kamera bei 12 MP Auflösung. Oben: Originalbild, unten: Vergrößerung des Bildausschnittes mit Gesicht. Die Werte unter den Bildern geben die Entfernung in Metern und die Größe des Gesichtes in Pixeln an.

Die Größenangaben sind nur Richtwerte und hängen insbesondere von dem gewählten Sensor und der verwendeten Optik ab. Abbildung 2 zeigt beispielhaft die Auflösung eines Gesichtes aus unterschiedlichen Entfernungen. Die Aufnahmen wurden mit einer GoPro Hero3+ und einer Auflösung von 4000 x 3000 Pixel und einem Sichtfeld von ca. 120° aufgenommen. Hierbei ist zu berücksichtigen, dass das Sichtfeld, auch FoV (Field-of-View) genannt, bei der GoPro verhältnismäßig groß ist. Bei einem kleineren FoV von z.B. 60° würde sich die Anzahl der Pixel die das Gesicht abdecken mehr als verdoppeln. In Abbildung 2 lässt sich erkennen, dass mit den gewählten Einstellungen eine Person bis ca. 3m identifizierbar und bis ca. 10m wiederzuerkennen ist. Befindet sich die Person in einer größeren Entfernung, kann man zwar noch eine Person detektieren, aber nicht mehr einer Identität zuordnen. Bei der Verwendung von UAVs ist noch darauf zu achten, dass im Normalfall von oben bzw. aus einem steilen Winkel auf die Personen geschaut wird. Dadurch ist das Gesicht einer Person deutlich schlechter zu erkennen, so dass eine Identifizierung einer Person mit dieser Ausstattung praktisch nicht möglich ist. Im Falle einer Wiedererkennungsaufgabe lassen sich in dem Fall allerdings noch statische und dynamische Merkmale der kompletten Person nutzen, z.B. Kleidung/Rucksack (statische Merkmale) oder Gangart/Verhalten (dynamische Merkmale), wobei dynamische Merkmale meist nur in Videos detektiert werden können.

Service

Aktivitäten

Aktuelle Ausgabe

Mit ihrem aktuellen und vielfältigen Themenspektrum, einer Mischung aus Theorie und Praxis und einem Team von renommierten Autorinnen und Autoren hat „Die Kriminalpolizei“ sich in den vergangenen Jahren einen ausgezeichneten Ruf erworben.

Erklärung einschlägiger Präventions-Begriffe

Meist gelesene Artikel

RSS Feed PolizeiDeinPartner.de

PolizeideinPartner.de - Newsfeed

-

Wie Betrüger Künstliche Intelligenz nutzen

Wenn uns jemand darauf aufmerksam macht, dass eine Überweisung getätigt wurde, die wir nicht...

-

Datenklau durch Scraping

Es gehört mittlerweile schon zur Normalität des Internets, dass immer wieder Fälle von...

-

Mehr Falschgeld in Deutschland

Ein Dutzend Vermögende sind 2023 in Deutschland beim Barverkauf ihrer teuren Uhren oder Autos von...

-

Verbraucherschutz-Training für Jugendliche

Gefahren durch Fake-Shops und Cyberkriminelle

-

Sommerreifen mit Bedacht wechseln!

Kälteeinbrüche auch im April möglich

-

Mehr Informationssicherheit für Feuerwehren

BSI und Feuerwehrverband starten gemeinsame Initiative

-

Statistik: Zahl der Verkehrstoten ist 2023 gestiegen

TÜV und DVR fordern Konsequenzen